几周前在 CES 上,我们介绍了铠侠 AiSAQ。该软件旨在用 SSD 替换 RAG AI 堆栈中的内存,以更低的成本实现更大的模型。另一个目标是最大限度地减少使用较低每 TB 设备成本对性能的影响。现在,该软件已经开源了:github传送门。

铠侠 AiSAQ SSD 支持的 RAG 用于更大规模的 AI 模型开源

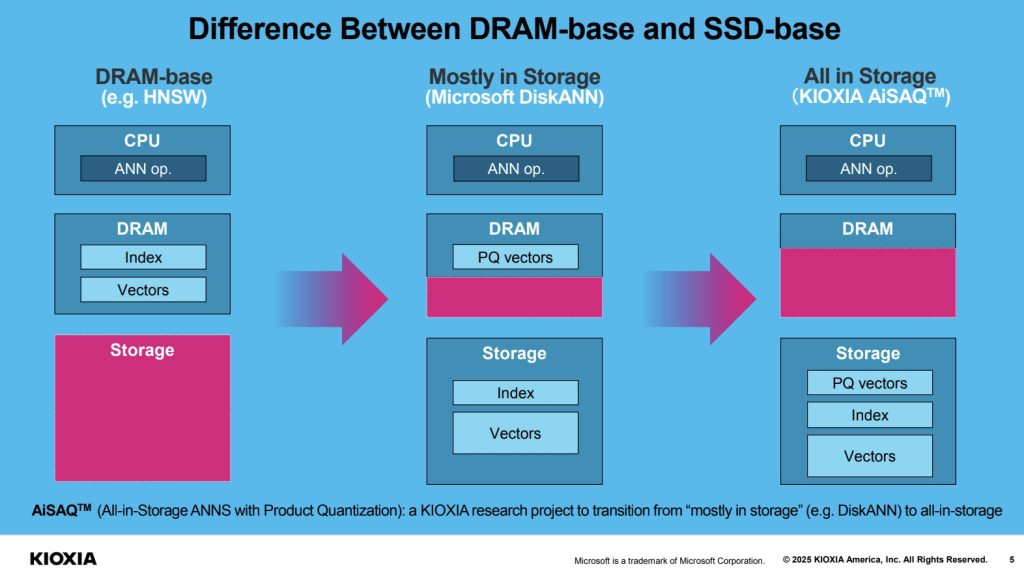

对于刚接触 RAG 或检索增强生成的人来说,这个想法很简单,LLM 可以访问数据源以提供训练集中不存在的上下文。例如,如果你有一个模型,以及一组不断刷新的业务数据。这往往会占用大量的内存和存储。 铠侠的 AiSAQ 是将向量数据和索引存储在存储中,而不是存储在一个巨大的内存池中,可以降低成本。

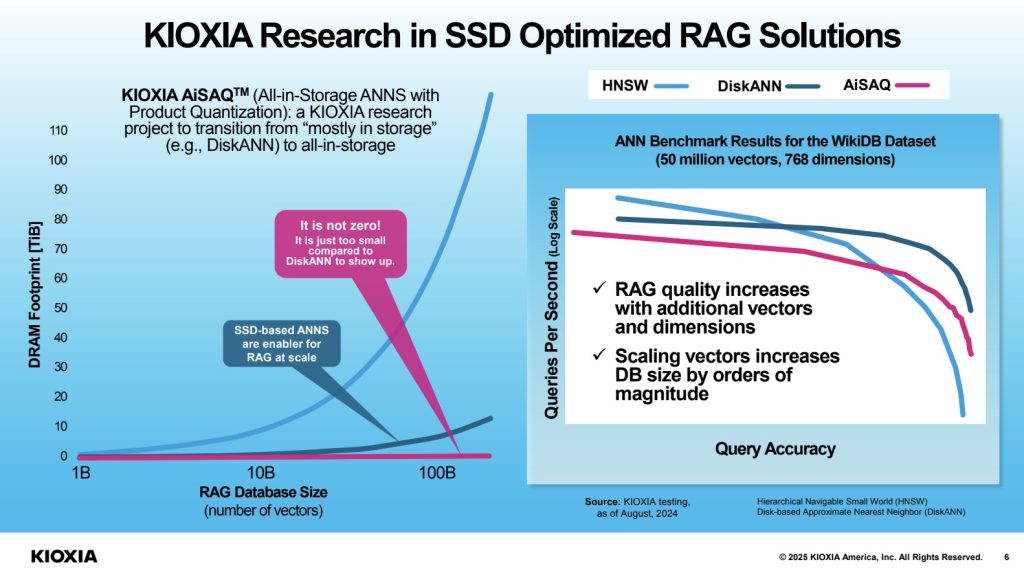

正如我们在上一篇文章中所讨论的, 访问信息是使用通常在 CPU 上完成的近似最近邻作或 ANN。Microsoft 有自己的 DiskANN,它可以将一些索引和向量数据移出 DRAM,但将乘积量化向量保留在 DRAM 中。使用 Kioxia AiSAQ,我们的想法是将所有这些数据移动到 SSD 上。

使用闪存代替 DRAM 可以降低成本,尤其是在 TB 级成本下。因此,铠侠表示,通过将所有内容移动到 SSD,它可以以最小的 DRAM 占用空间存储大量矢量。

这样做的一个缺点是它可能比使用所有 DRAM 慢,但好处是达到给定规模的成本更低。更高的规模可能意味着更高的质量或更准确的结果。

最后

这是人们可能想要使用的新工具。现在,AiSAQ 已经开源并在 Github 上,可以使用。也许这是人们觉得有用的东西。也许不是。至少它在那里。

文章评论