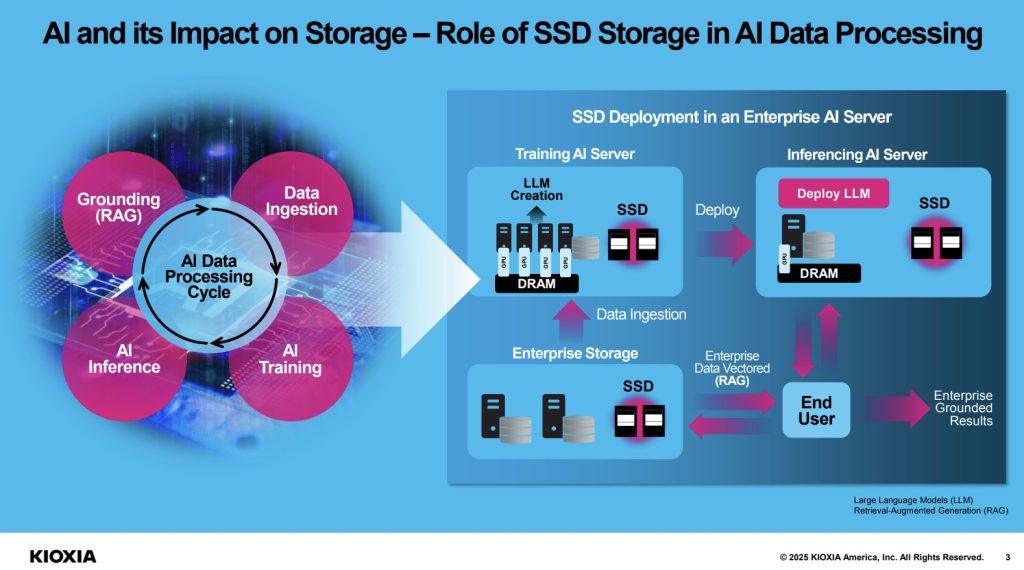

作为 CES 的一部分,铠侠本周正在做一些不同的事情。它没有谈论消费类 SSD,而是专注于铠侠 AiSAQ 产品,该产品希望用 SSD 取代 AI 堆栈中的内存,以更低的成本实现更大的模型。

对于刚接触 RAG 或检索增强生成的人来说,这个想法很简单,LLM 可以访问数据以帮助它减少幻觉,并提供重要的上下文。例如,LLM 不仅可以根据可能几个月前的训练数据集输出信息,还可以访问当前信息并将其引入之前训练的 LLM。所有这些都需要大量的内存和存储。

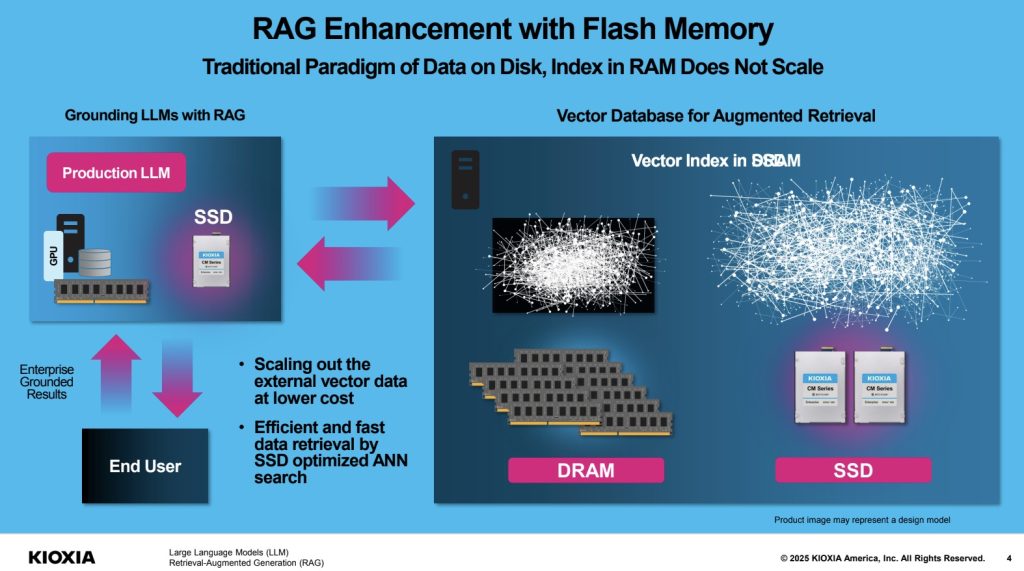

Kioxia 的想法是,将向量数据和索引存储在存储中,而不是存储在巨大的内存池中,可以节省很多成本。

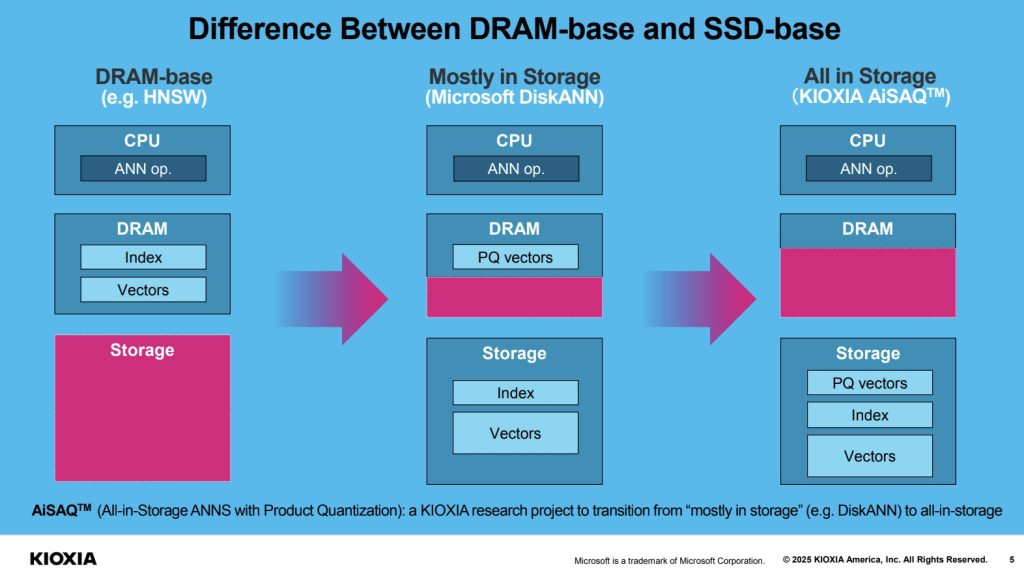

通常使用通常在 CPU 上完成的近似最近邻作或 ANN 来访问信息。Microsoft 的 DiskANN 可以将一些索引和矢量数据移出 DRAM,但将乘积量化矢量保留在 DRAM 中。借助铠侠 AiSAQ,我们的想法是将所有这些数据移动到 SSD 上。

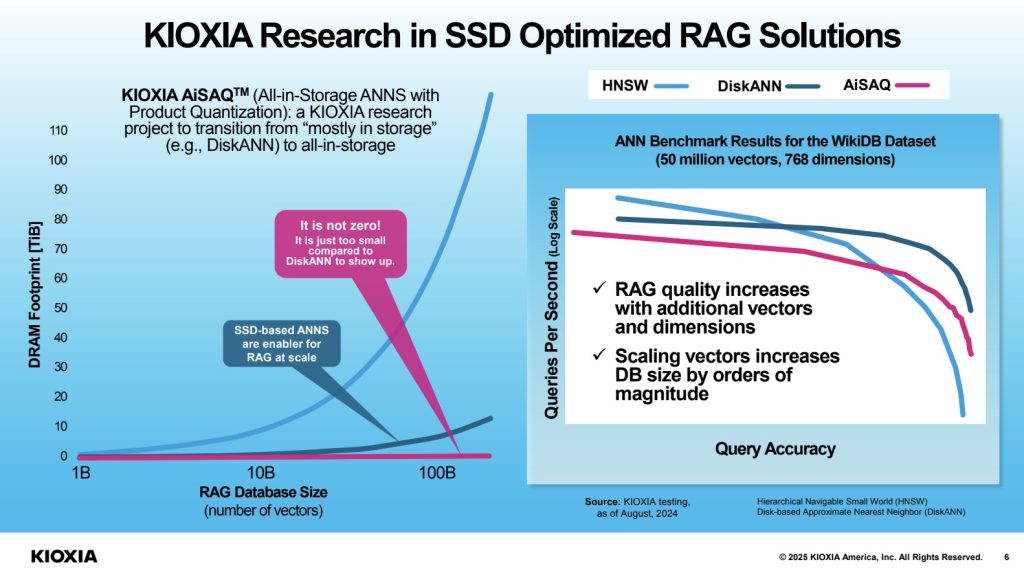

使用闪存代替 DRAM 可以降低成本,尤其是在 TB 级成本下。因此,铠侠表示,通过将所有内容移动到 SSD,它可以以最小的 DRAM 占用空间存储大量矢量。

这样做的一个缺点是它可能比使用所有 DRAM 慢,但好处是达到给定规模的成本更低。更高的规模可能意味着更高的质量或更准确的结果。

最后

如今,一切都是人工智能,铠侠也在推动这一点。实际上,RAG 将成为许多应用程序的重要组成部分,如果有一个应用程序需要访问大量数据,但使用频率不高,那么对于像铠侠 AiSAQ 这样的人来说,这将是一个很好的机会。希望我们将来能向您展示更多这样的内容。

文章评论