今天我们有一个相当令人兴奋的作品。这是我们首次亲身体验专为不同的横向扩展部署模型设计的新型 SSD。铠侠 EM6 是一款 NVMeoF SSD,它使用以太网和 RDMA 而不是 PCIe/NVMe、SAS 或 SATA 来连接机箱。我们亲身实践向您展示为什么这是一项非常酷的技术。

什么是以太网SSD?请观看以下视频

Ingrasys ES6 中的铠侠 EM2000 NVMeoF SSD

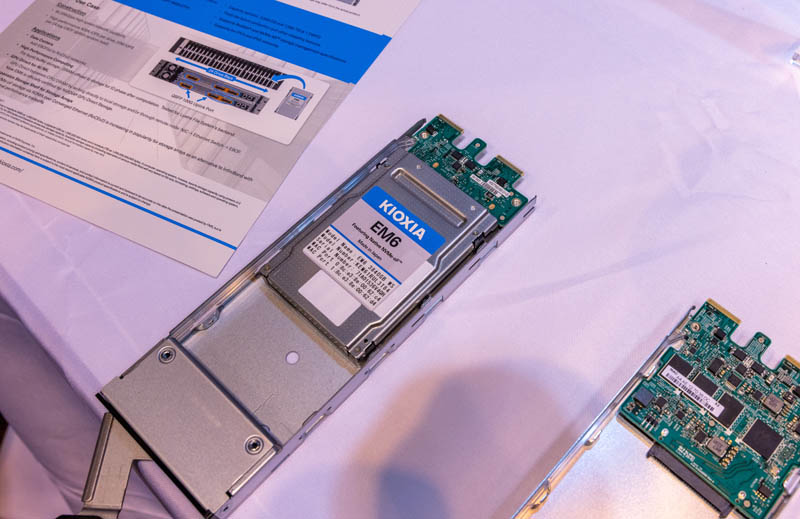

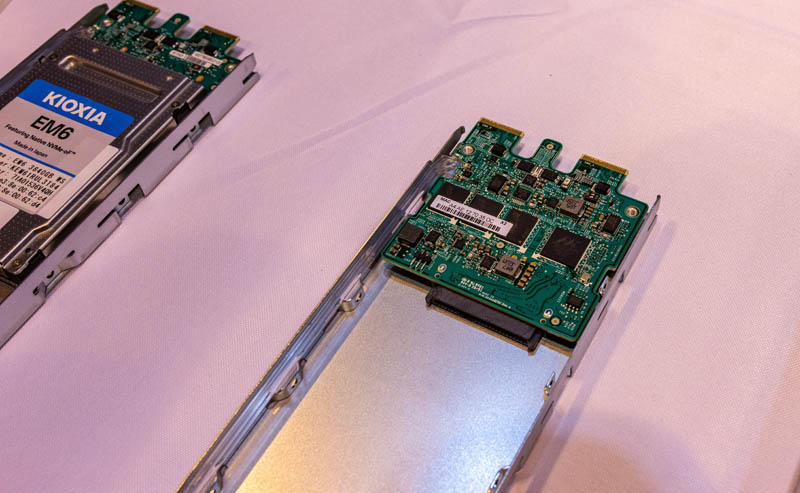

首先,整个解决方案中最大的变化是铠侠 EM6 SSD。这可能看起来像一个普通的 2.5 英寸 SSD,但有一个很大的区别,它的 I/O 是以太网而不是传统的 PCIe/NVMe。可以看到 Ingrasys ES2000 背夹上有两个 EDSFF 连接器。这是为了保持与传统 NVMe 产品的通用设计,但它突出了另一个特点。这些是用于冗余的双端口 NVMeoF SSD。这是一项重要功能,使他们能够在传统上由双端口 SAS SSD 服务的市场中竞争。

我们在 SC21展会上研究了用于铠侠 EM6 NVMe-oF SSD 的 Ingrasys ES2000。不过,这是我们第一次真正使用该系统。

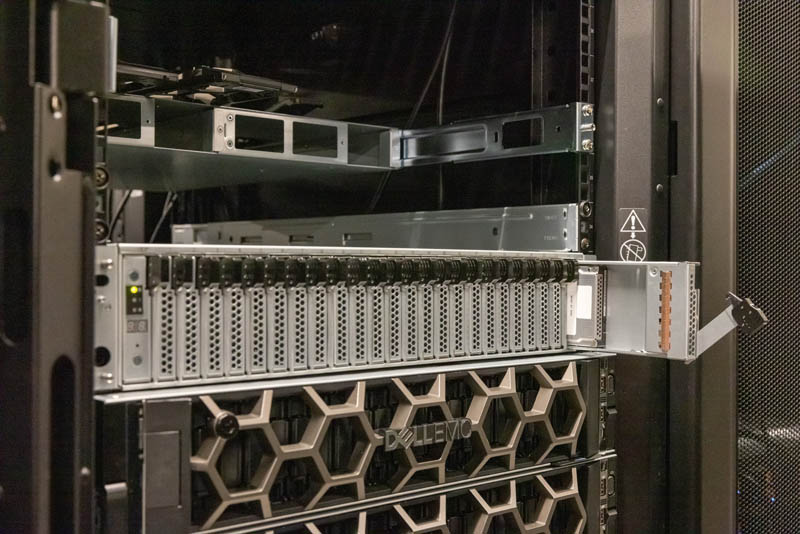

在铠侠实验室中,我们不得不使用旧版本的机箱,但可以看到它是一个 24 盘位的 2U,看起来就像我们多年来看到的许多其他服务器和存储架一样。

我们在视频中展示了这一点,但我们实际上可以热插拔 EM6 SSD。EDSFF 连接器专为热插拔而设计,当然,以太网网络旨在处理设备上线/离线的设备。

以下是驱动器插入的背板。如您所见,我们有 EDSFF 连接器,但即使驱动器托盘有两个连接器,也只有一个。

这是因为每个机箱中有两个。以下是有机玻璃盖下的开关节点。

查看系统的背面,我们可以看到两个开关。此特定系统仅连接了顶部节点。另外,有趣的是,由于这是一个以太网交换机节点,我们可以有 1-6 个连接,而在这个系统中,使用的一个连接是 100GbE。

还可以看到每个网络交换机托盘都有一个 USB 端口、一个带外管理端口和一个串行控制台端口。虽然它们可能看起来像服务器,但这些是交换机。

在系统内部,我们可以看到 Marvell 98EX5630 开关芯片被大散热器覆盖。Marvell 还在 EM6 SSD 中制造 NVMe 转以太网控制器。

黑色散热器下方还有一个用于开关的控制平面。它由 Intel Atom C3538 CPU 以及 M.2 SSD 和 8GB DRAM 提供支持。

这些交换机一个堆叠在另一个上面,允许每个驱动器同时访问两个交换机网络,从而提供到驱动器的冗余路径。

对于那些想知道的人来说,有一个 Marvell 88SN3400 适配器卡可以将传统的 NVMe SSD 连接到以太网,以便可以在此机箱中使用。

接下来,让我们动手实践一下,看看我们可以用铠侠 EM6 SSD 做一些有趣的事情。

Ingrasys ES2000 和 Kioxia EM6 NVMeoF SSD 动手设置

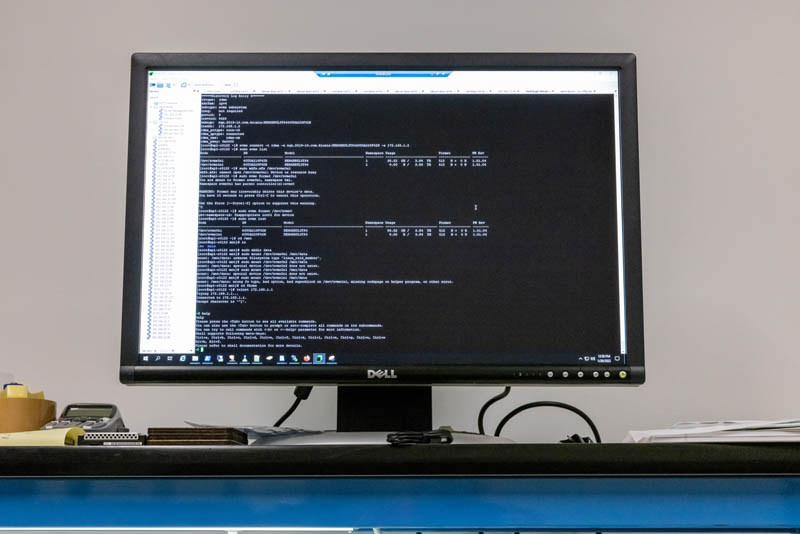

也许 Ingrasys ES2000 系统最酷的功能之一是交换机运行 SONiC。这是一个完全软件定义的网络解决方案,在两台交换机上运行。强调我们有到各种 EM6 SSD 的 25GbE 链路。

另一个有趣的事实是,由于驱动器是基于网络的,我们不仅可以 ping 作,还可以 Telnet 连接到它们。这些驱动器的终端非常有限,但对于实验室来说,能够执行管理固件更新等作非常有用。

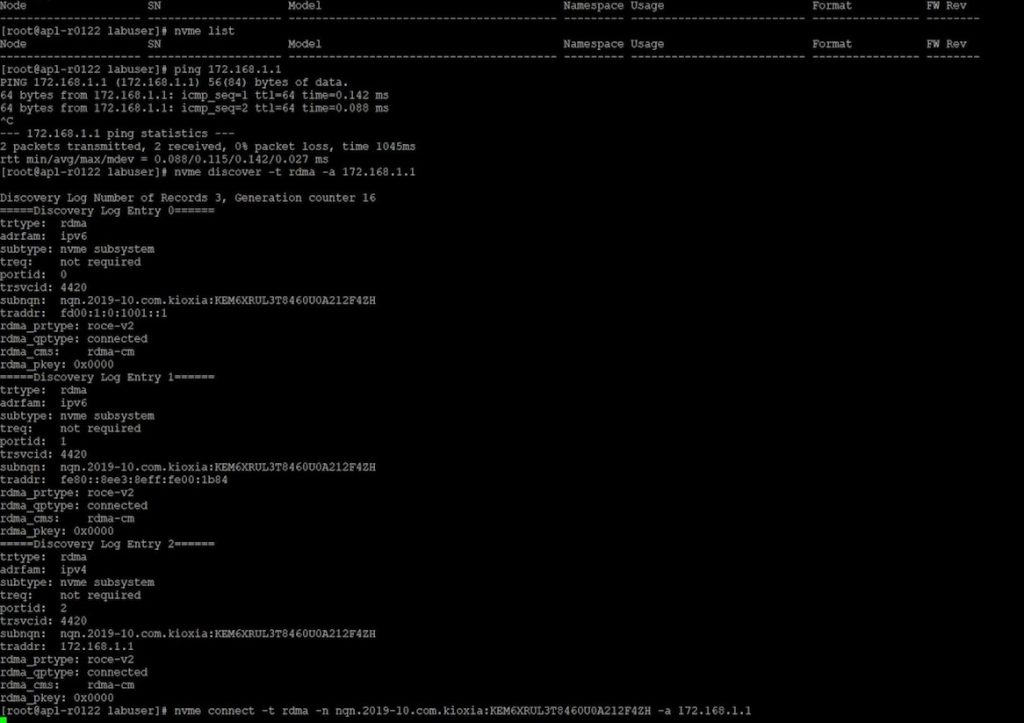

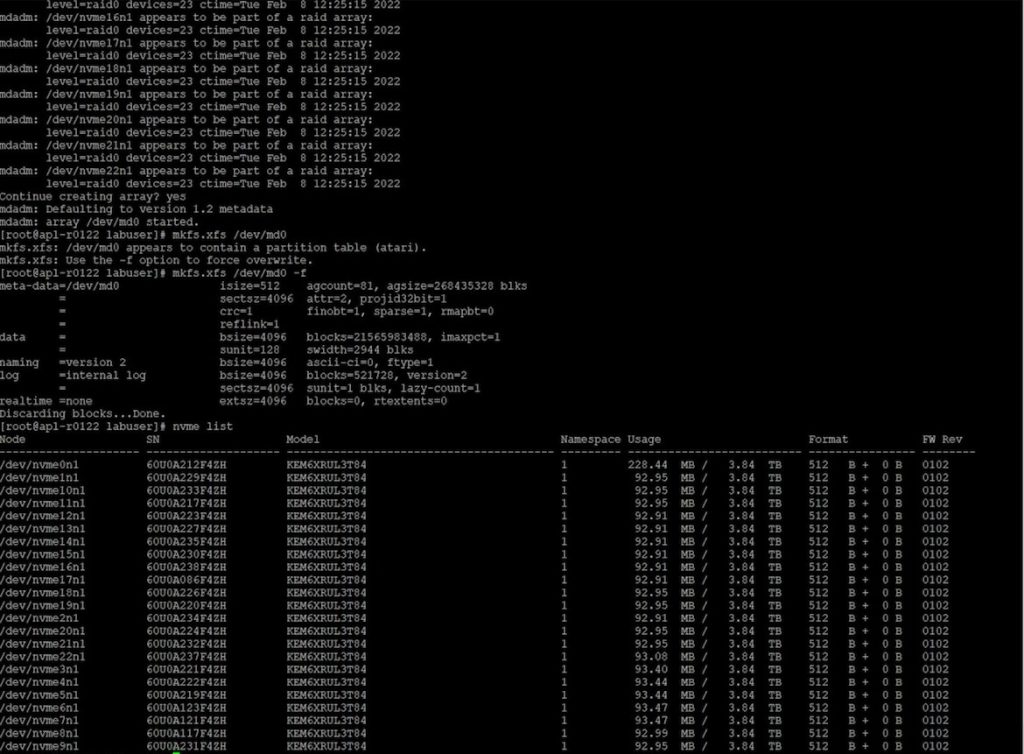

接下来,我们设置一个驱动器。我们可以看到,我们从工作站中没有 NVMe 设备开始,可以通过网络发现 EM6 设备。

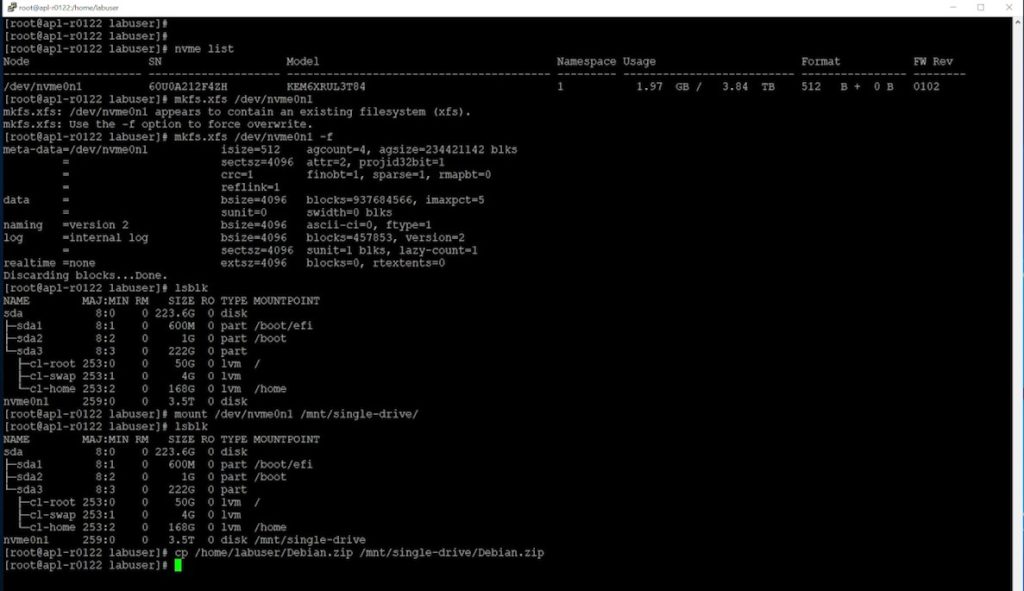

然后我们可以连接到驱动器,挂载 NVMeoF 驱动器,创建一个文件系统,然后开始向其传输数据。

一个驱动器很有趣,但我们也可以用更多的驱动器做同样的事情。接下来,我们使用 23 个 3.84TB EM6 SSD 来做这件事。脚本错误阻止了第 24 个驱动器的添加。

然后,我们可以将这 23 个驱动器 RAID 0,制作文件系统,并挂载超过 80TB 的可用性。

从这里,我们可以开始传输数据,然后在网络上的驱动器之间进行条带化。在这种情况下,所有驱动器都位于同一机箱中,但由于它是一个 IP 网络,因此几乎没有理由不能将它们连接到数据中心的多个机箱、机架和行中。

接下来,让我们来看看这个 “so what”。

为什么这对网络存储的未来很重要?

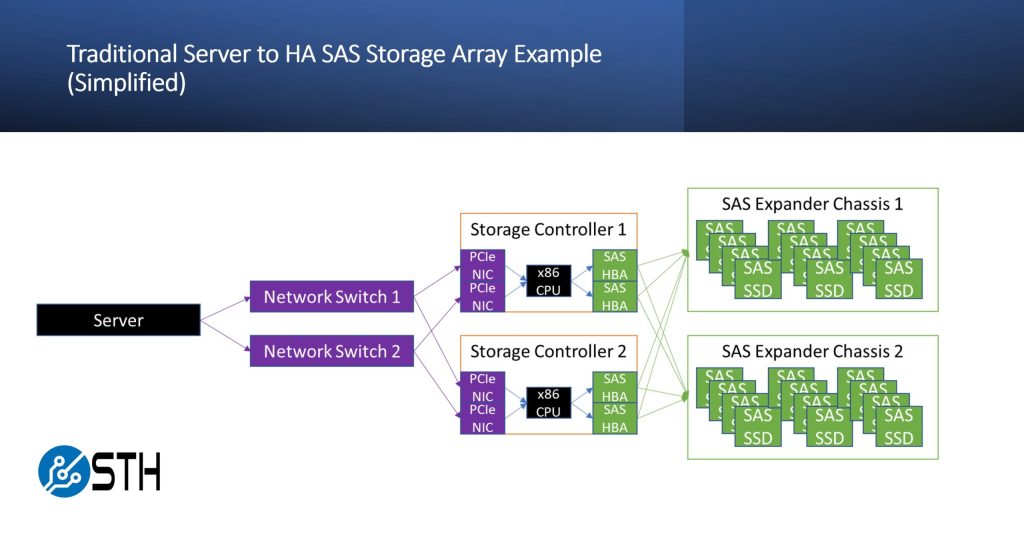

退一步讲,拥有高可用性 SAS 存储阵列的想法似乎很简单,但还有很多事情要做。想要获取数据的服务器必须通过以太网发送请求。该请求由交换机处理,然后转到存储控制器。然后,该消息通过 PCIe 发送到主机 CPU,通常是 x86 CPU。然后,x86 CPU 需要确定要做什么,然后通过 PCIe 向 SAS HBA 或 RAID 控制器发出命令。从那里,SAS 命令通常会通过 SAS 扩展器到达 SAS SSD。实际上,这是很多步骤。

铠侠 EM6 模型通过将驱动器直接放在网络上,意味着请求通过基础设施传输到使用以太网的驱动器。它还在拓扑中创建了更少的“阻塞点”,因为消息传递不需要通过存储控制器。网络和管理方面存在复杂性,但这种设计消除了整块复杂性。人们已经弄清楚了如何在这一点上相当好地扩展 IP 网络,并且比 SAS/NVMe 阵列扩展到更多的连接设备。

这一点的真正强大之处,也是我们没有展示的,是当涉及到命名空间时。每个驱动器都可以分区为多个较小的命名空间。在我们的 RAID 0 示例中,想象一下,如果系统不使用一个 2TB 驱动器或 23 个 3.84TB 驱动器,而是使用来自 23 个驱动器的 100GB 命名空间,然后具有额外的奇偶校验容量。这最大限度地减少了给定驱动器上的数据量。虽然它增加了设备发生故障的可能性,但它减少了故障的影响,从而提高了可靠性。这也意味着有更多的性能可用于饱和 NIC 带宽,因为数据是同时从多个驱动器中提取的。

我们在这里使用 RAID 作为一个简单的示例,但这些可能是 Ceph OSD、GlusterFS 驱动器或使用其他存储解决方案。对于主机系统来说,这些看起来与普通的 NVMe SSD 非常相似,这是功能的一部分。

最后

总的来说,这不会在一夜之间取代所有 SAS 阵列。这是一个巨大的技术变化。同时,很容易看出这种存储和管理方式对许多组织的吸引力。现在,设备已准备就绪,我们将开始看到围绕这些驱动器构建的部署和解决方案。如果我今天要建立一家存储初创公司,Koixia EM6 将是我非常感兴趣的集成技术,因为它为市场提供了不同的东西。

展望未来,应该首先考虑的问题是管理。因此,本系列的下一部分将介绍 DPU 并通过 DPU 管理存储配置,以便基础设施提供商可以保护和分配 NVMeoF 设备等解决方案的容量。请继续关注。

Tips

文章来源于STH,详情请查询:click here.

文章评论