也许我们最兴奋的技术之一是以太网 SSD。Toshiba(现为 Kioxia)和 Marvell 多年来一直在展示概念设备。现在,铠侠Ethernet SSD(以太网硬盘)正在成为现实,并正在向某些客户和合作伙伴提供样品。这可能不是我们热切期待的正式发布公告,但作为下一步,它非常令人兴奋。铠侠已经看到了人们对该产品的足够兴趣,并继续向商业化发展。

铠侠以太网 SSD 背景

这个概念相对简单,我们看到多家公司从不同角度进行攻击。在行业中,随着 NVMeoF 等技术变得既可行又受欢迎,闪存存储是否需要直接连接到 x86 节点,人们越来越质疑。一些 SmartNIC 能够在 NIC 上运行 NVMeoF 堆栈,因为它相对轻量级,并且可以使用 PCIe 点对点传输直接访问同一系统中的存储。我们看到 Mellanox Bluefield-2 系列、Fungible F1 DPU 和 Pensando 分布式服务架构 SmartNIC 等设备具有将多个 SSD 直接连接到基于 Arm/MIPS 的设备,然后直接暴露在网络中的方法,即使没有 x86 主机也是如此。

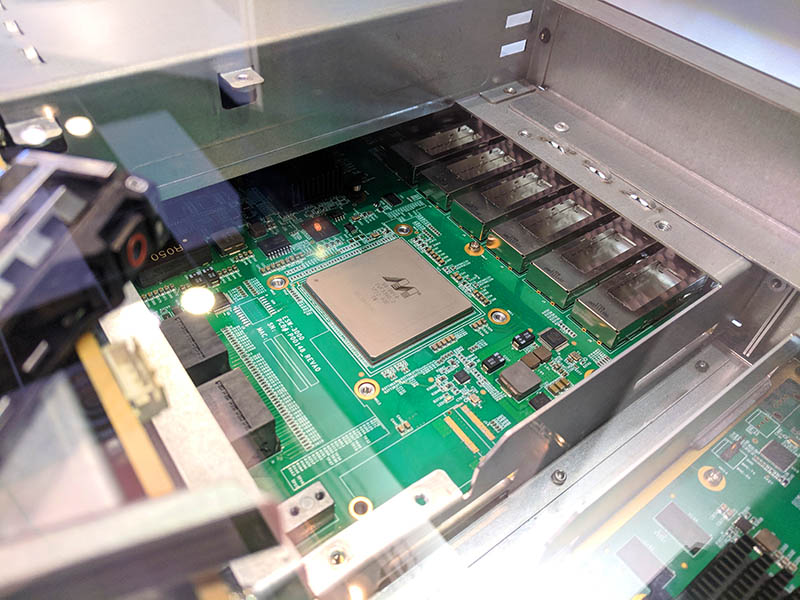

铠侠和 Marvell 一直在研究不同的策略。每个驱动器上的主机接口可以是以太网而不是 PCIe,而不是通过中间处理器。事实上,PCIe Gen3 x4 的带宽大约相当于 25GbE 通道,因此这些比率是有道理的。实现这项工作的关键是 Marvell 的 88SN2400 控制器。Marvell 的控制器允许将 SSD 作为 NVMeoF 目标直接放置在网络上。

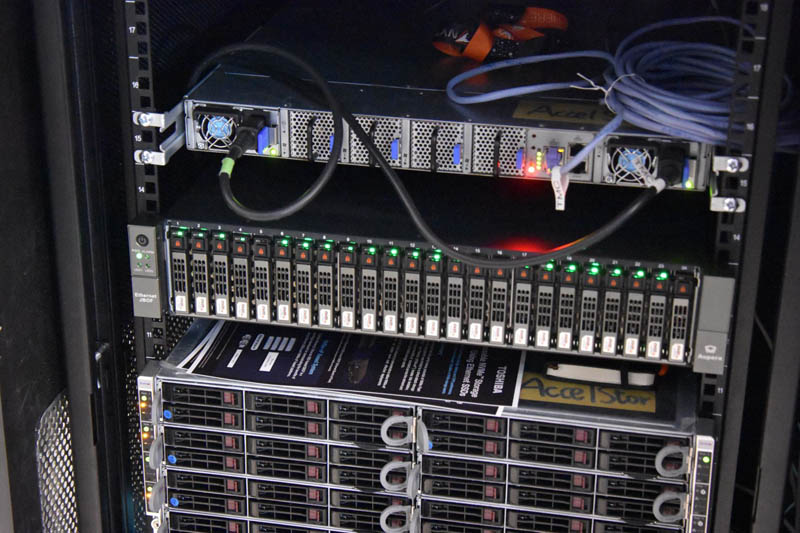

如您所见,每个 SSD 都有两条路径连接到两个不同的交换机,从而允许与每个设备建立高可用性连接,类似于我们在传统 SAS 存储阵列中获得的。Marvell(和铠侠)展示了使用 Marvell 网络交换机处理链路的解决方案。可以看到机箱背面的八个 QSFP28 连接器,如下所示。这允许机箱外部具有全部带宽。

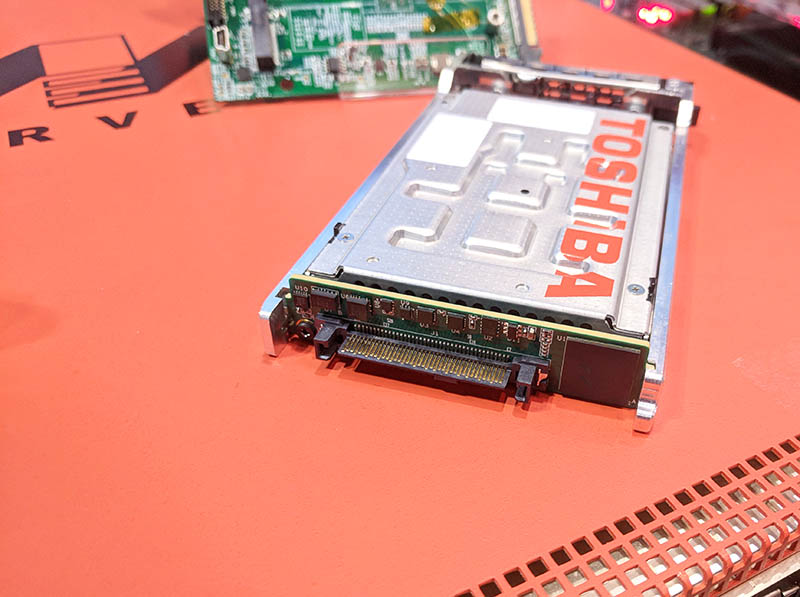

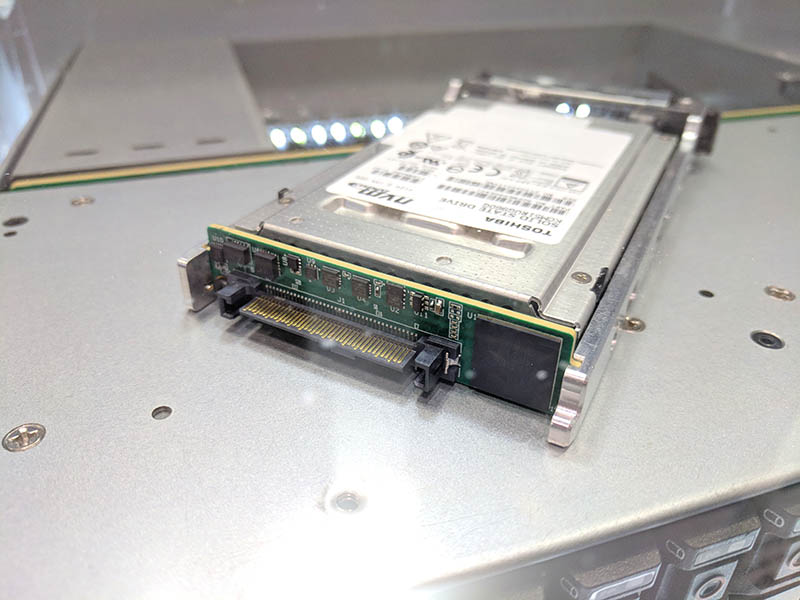

2018 年,该产品概念是一种 SSD,其外部板连接到标准 SSD 的 2.5 英寸连接器。到 FMS 2019 时,控制器已直接集成到 SSD 本身中。在这里,我们可以看到铠侠以太网 SSD(以前称为东芝),它集成了受控并直接输出到可插拔笼。

无论是内置于高可用性机箱中,还是采用更直接的网络设计,每个 SSD 都可以添加为网络终端节点并提供 NVMeoF 目标。

该解决方案正在转向客户/合作伙伴抽样,这是一个好兆头。

新闻稿中的亮点

EBOF 系统亮点:

- 更简单的 EBOF 设计,铠侠以太网 SSD 直接连接到 EBOF 内部的嵌入式以太网交换机

- 可用的 EBOF 2U 系统可以连接多达 24 个铠侠以太网 SSD,总存储吞吐量高达 600 Gbps。

- 每个系统都支持 2.4 TB/s 的连接吞吐量,可以在网络连接和菊花链式其他 EBOF 之间进行拆分

- 高性能:每个驱动器 670K IOPS,每 24 个托架 EBOF 超过 16M IOPS(@4KB 随机读取)

- 运行 Marvell EBOF SDK,利用 SONiC 网络作系统并实现高级发现和管理功能

铠侠的新驱动器将 Marvell® NVMe-oF™ 以太网 SSD 转换器控制器集成到其企业级 NVMeTM SSD 中,无需外部以太网到 NVMe 桥接适配器。

铠侠以太网 SSD 特点:

- 支持单或双 25Gb 以太网和 RoCEv2 RDMA 连接

- NVMe-oF 1.1 和 NVMe 1.4 合规性

- 2.5 英寸 1 15 毫米 (mm) Z 高度外形尺寸

- 支持的容量:1920/3840/7680 GB

- 双晶片故障恢复和其他可靠性功能

- 支持 Redfish® 和 NVMe-MI™ 存储管理规范

- 支持 IPv4 和 IPv6 架构

(以上信息来源于铠侠)

最后

如果我们超越今天的公告,展望未来,这是非常强大的。NVMe SSD 本身可以具有 IPv6 地址,而不是 NVMe SSD 通过 x86 服务器的 PCIe 通道(可能的 PCIe 交换机)连接到网络,或者 SAS SSD 通过 SAS 交换机传输到 x86 服务器的 PCIe 通道到网络。多个服务可以使用 RoCEv2 通过标准以太网设备通过网络获得高速访问。这大大简化了设计,因为以太网 SSD 解决方案中遍历的跳数更少,并且遍历的接口也更少。

在这样的 NVMeoF 解决方案中,一部分是硬件,另一部分是软件支持。铠侠一直在开发其 Kumoscale NVMeoF 软件解决方案,以解决这一问题。

我们仍然无法获得这些 SSD,甚至 Marvell PCIe 转 25GbE 适配器,但我们仍然希望有一天可以展示这一点。

Tips

文章来源于STH,原文链接:click here.

文章评论